Google Colaboratoryで学ぶ!あたらしい人工知能技術の教科書 機械学習・深層学習・強化学習で学ぶAIの基礎技術

我妻 幸長 著

- 形式:

- 電子書籍

- 発売日:

- 2021年09月08日

- ISBN:

- 9784798167213

- 価格:

- 3,740円(本体3,400円+税10%)

- カテゴリ:

- 人工知能・機械学習

- キーワード:

- #プログラミング,#開発手法,#データ・データベース,#ビジネスIT

- シリーズ:

- AI & TECHNOLOGY

最新のAI開発プラットフォームで

機械学習・深層学習・強化学習の

基礎技術を学ぼう!

【本書の概要】

本書はUdemyで大人気の講座

『AIパーフェクトマスター講座 -Google Colaboratoryで隅々まで学ぶ実用的な人工知能/機械学習-』をもとにした書籍です。

・機械学習(回帰、k平均法、サポートベクターマシン)

・深層学習(画像識別や画像生成、RNN)

・強化学習(Cart Pole問題、深層強化学習)

といった、AI開発でニーズの高い人工知能技術を、深層学習を中心に解説しています。

また本書ではサンプルを用意していますので、サンプルを動かしながら、AI技術の仕組みを理解できます。

開発環境にはGoogle Colaboratoryを使用します。

【Google Colaboratoryとは】

ブラウザ上で利用できる機械学習や深層学習向けの開発環境です。

GPUを無料で利用できるので、コードの実行時間を大幅に短縮できます。

【本書ポイント】

・機械学習・深層学習・強化学習の基礎知識を一気に学べる

・Pythonでコードを動かしながら機械学習・深層学習・強化学習の理論を学べる

【対象読者】

・何らかのプログラミング経験のある方

・機械学習・深層学習・強化学習を学ぶ意欲のある方

・高校数学以上の数学知識のある方

【著者プロフィール】

我妻幸長(あづま・ゆきなが)

SAI-Lab株式会社を起業。「ヒトとAIの共生」がミッション。

人工知能(AI)関連の研究開発、教育、アプリ開発が主な事業。

著者のYouTubeチャンネルでは、無料の講座が多数公開されている。

※本電子書籍は同名出版物を底本として作成しました。記載内容は印刷出版当時のものです。

※印刷出版再現のため電子書籍としては不要な情報を含んでいる場合があります。

※印刷出版とは異なる表記・表現の場合があります。予めご了承ください。

※プレビューにてお手持ちの電子端末での表示状態をご確認の上、商品をお買い求めください。

(翔泳社)

お問い合わせ

内容についてのお問い合わせは、正誤表、追加情報をご確認後に、お送りいただくようお願いいたします。

正誤表、追加情報に掲載されていない書籍内容へのお問い合わせや

その他書籍に関するお問い合わせは、書籍のお問い合わせフォームからお送りください。

利用許諾に関するお問い合わせ

本書の書影(表紙画像)をご利用になりたい場合は書影許諾申請フォームから申請をお願いいたします。

書影(表紙画像)以外のご利用については、こちらからお問い合わせください。

-

6.1節のボストン住宅価格データセットについて(2023年5月)

2023年5月現在、P.178~P.187で利用していますボストン住宅価格データセットですがライブラリ側より提供が中止されています。

新しくカリフォルニア住宅価格データセットを元にした、解説文とサンプル(ノートブック)を用意しましたので、こちらをご参考にしてください。

-

リスト4.2、リスト4.10のコードについて(2023年10月)

2023年10月現在、P.96のリスト4.2、P.110のリスト4.10で、ライブラリのバージョンアップによりエラーが発生します。

以下のように修正してください。

【誤】

…

from keras.utils import np_utils

…

t = np_utils.to_categorical(iris.target)

【正】

…

import tensorflow as tf

…

t = tf.keras.utils.to_categorical(iris.target)

-

リスト11.8、リスト11.9、リスト11.13、リスト11.15のコードについて(2023年11月)

Google Colaboratoryのライブラリのバージョンアップにより修正が必要になりました。

リスト11.8を以下のように変更してください。なおエラー対策として、最後にbox2d-pyをアンイストール後、再びインストールしています。

------------------------

!pip install setuptools==65.5.1 wheel==0.38.4 -U

!apt-get update

!apt install swig cmake libopenmpi-dev zlib1g-dev

!pip install stable-baselines3==1.6.0 box2d box2d-kengz pyvirtualdisplay

!apt-get install -y xvfb freeglut3-dev ffmpeg

!pip install PyOpenGL PyOpenGL_accelerate

!pip install pyglet==1.5.27

!pip uninstall box2d-py

!pip install box2d-py

------------------------

リスト11.9を以下のように変更してください。

------------------------

import os

import io

import glob

import base64

import gym

import numpy as np

from stable_baselines3.common.vec_env import DummyVecEnv # ベクトル化環境

from stable_baselines3 import DQN

from stable_baselines3.common.vec_env import VecVideoRecorder

from IPython import display as ipythondisplay

from IPython.display import HTML

import warnings

warnings.filterwarnings("ignore")

------------------------

リスト11.13のMlpPolicyの部分を"MlpPolicy"に変更してください。

[変更前]

model = DQN(MlpPolicy, env, verbose=0) # DQNの設定

[変更後]

model = DQN("MlpPolicy", env, verbose=0) # DQNの設定

リスト11.15のMlpPolicyの部分を"MlpPolicy"に変更してください。

[変更前]

trained_model = DQN(MlpPolicy, env_vec, verbose=0) # モデルの初期化

[変更後]

trained_model = DQN("MlpPolicy", env_vec, verbose=0) # モデルの初期化

------------------------------

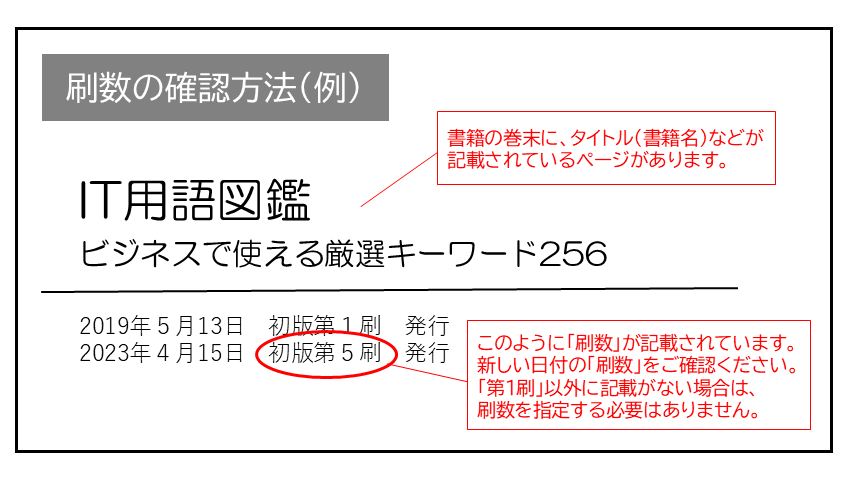

現在表示されている正誤表の対象書籍

書籍の種類:電子書籍

書籍の刷数:全刷

書籍によっては表記が異なる場合がございます

本書に誤りまたは不十分な記述がありました。下記のとおり訂正し、お詫び申し上げます。

対象の書籍は正誤表がありません。

山のトンネル さん

2022-04-08

1週間もあれば読み切れそうな難易度。pythonの触りの触りが学べる。

ᚹγअәc0̸א さん

VAEいじくりでお手軽デザイナー気分