Pythonによるあたらしいデータ分析の教科書 第2版

寺田 学 著

辻 真吾 著

鈴木 たかのり 著

福島 真太朗 著

- 形式:

- 書籍

- 発売日:

- 2022年10月24日

- ISBN:

- 9784798176611

- 定価:

- 2,838円(本体2,580円+税10%)

- 仕様:

- A5・336ページ

- カテゴリ:

- プログラミング・開発

- キーワード:

- #プログラミング,#開発環境,#開発手法,#Web・アプリ開発

- シリーズ:

- AI & TECHNOLOGY

読者の声に応えて第2版の登場!

データ分析エンジニアに必要な

基本技術をしっかり習得できる

【本書の概要】

本書はデータ分析エンジニアに必要な

以下の基礎技術を丁寧に解説しています。

・データの取得・加工

・データの可視化

・プログラミング

・基礎的な数学の知識

・機械学習の流れや実行方法

【第2版のポイント】

・Python 3.10対応

・よりわかりやすい解説

・Pythonデータ分析試験の主教材に指定

【本書で学べること】

・Pythonの基本的な文法

・データフォーマットについて

・データの前処理技術

・データの可視化技術

・既存アルゴリズムでの機械学習の実装方法

【対象読者】

データ分析エンジニアを目指す方

【目次】

第1章 データ分析エンジニアの役割

第2章 Pythonと環境

第3章 数学の基礎

第4章 ライブラリによる分析の実践

第5章 応用:データ収集と加工

1.1 データ分析の世界

1.1.1 データ分析を取り巻く状況

1.1.2 データ分析とPython

1.1.3 データサイエンティストとは

1.1.4 データ分析エンジニアとは

1.1.5 データハンドリング(前処理)の重要性

1.2 機械学習の位置づけと流れ

1.2.1 機械学習とは

1.2.2 データからモデルを作る

1.2.3 機械学習のタスク

1.2.4 機械学習の処理の手順

1.3 データ分析に使う主なパッケージ

1.3.1 パッケージとは

1.3.2 サードパーティ製パッケージの紹介

Chapter 2 Pythonと環境

2.1 実行環境構築

2.1.1 Python公式版をインストール

2.1.2 venv: Pythonの仮想環境

2.1.3 pipコマンド

2.1.4 Anaconda

2.2 Pythonの基礎

2.2.1 Pythonの文法

2.2.2 基本構文

2.2.3 標準ライブラリ

2.3 JupyterLab

2.3.1 JupyterLabとは

2.3.2 JupyterLabのインストール

2.3.3 基本的な使い方

2.3.4 便利な使い方

2.3.5 第4章以降で使用する環境の準備

Chapter 3 数学の基礎

3.1 数式を読むための基礎知識

3.1.1 数式と記号

3.1.2 数学記号

3.1.3 関数の基本

3.2 線形代数

3.2.1 ベクトルとその演算

3.2.2 行列とその演算

3.3 基礎解析

3.3.1 微分と積分の意味

3.3.2 簡単な関数の微分と積分

3.3.3 微分と関数の値

3.3.4 偏微分

3.4 確率と統計

3.4.1 統計の基礎

3.4.2 データの可視化方法

3.4.3 データとその関係性

3.4.4 確率

3.4.5 確率分布

3.4.6 確率と関数

3.4.7 確率と情報量

Chapter 4 ライブラリによる分析の実践

4.1 NumPy

4.1.1 NumPyの概要

4.1.2 NumPyでデータを扱う

4.1.3 NumPyの各機能

4.2 pandas

4.2.1 pandasの概要

4.2.2 データの読み込み・書き込み

4.2.3 データの整形

4.2.4 時系列データ

4.2.5 欠損値処理

4.2.6 データ連結

4.2.7 統計データの扱い

4.3 Matplotlib

4.3.1 Matplotlibの概要

4.3.2 描画オブジェクト

4.3.3 グラフの種類と出力方法

4.3.4 スタイル

4.3.5 pandasのオブジェクトからグラフ描画

4.4 scikit-learn

4.4.1 前処理

4.4.2 分類

4.4.3 回帰

4.4.4 次元削減

4.4.5 モデルの評価

4.4.6 ハイパーパラメータの最適化

4.4.7 クラスタリング

Chapter 5 応用:データ収集と加工

5.1 スクレイピング

5.1.1 スクレイピングとは

5.1.2 スクレイピング環境の準備

5.1.3 Webページをダウンロード

5.1.4 Webページから要素を抜き出す

5.1.5 書籍の一覧を抜き出す

5.1.6 スクレイピングで気を付けること

5.1.7 次のステップ

5.2 自然言語処理

5.2.1 必要なライブラリのインストール

5.2.2 形態素解析

5.2.3 Bag of Words(BoW)

5.2.4 TF-IDF

5.2.5 極性判定

5.3 画像データの処理

5.3.1 画像を扱う準備

5.3.2 画像データの基本

5.3.3 簡単な画像の処理

5.3.4 数値データとしての画像

5.3.5 機械学習を使った画像の分類

付属データはこちら

お問い合わせ

内容についてのお問い合わせは、正誤表、追加情報をご確認後に、お送りいただくようお願いいたします。

正誤表、追加情報に掲載されていない書籍内容へのお問い合わせや

その他書籍に関するお問い合わせは、書籍のお問い合わせフォームからお送りください。

利用許諾に関するお問い合わせ

本書の書影(表紙画像)をご利用になりたい場合は書影許諾申請フォームから申請をお願いいたします。

書影(表紙画像)以外のご利用については、こちらからお問い合わせください。

-

よくある質問

Q:P.154でpandas 2.x以降を利用する場合

A:本書で解説している環境とは異なりますが、pandas 2.0 以降(pandas 2.1でも同様)で同じ属性を上書きする場合は、

df.loc[:, "摂取カロリー"] = XXXX

の先頭を変更し、以下のようにすることで解消します。

df["摂取カロリー"] = XXXX

Q:P.175でpandas 2.0.xを利用する場合

A:numeric_onlyという引数がcorr()メソッドにが導入されたのが、pandas1.5.0となります。numeric_only のdefaultがFalseに変わったのが pandas2.0.0です。

pandas 1.5.0以降で、corr()メソッドを使うと、数値型以外の列で発生します。

pandas 1.5.0以降を利用する場合は、P.175の相関係数の「In」を以下のように変更してください。

--------------------

df.corr(numeric_only=Ture)

--------------------

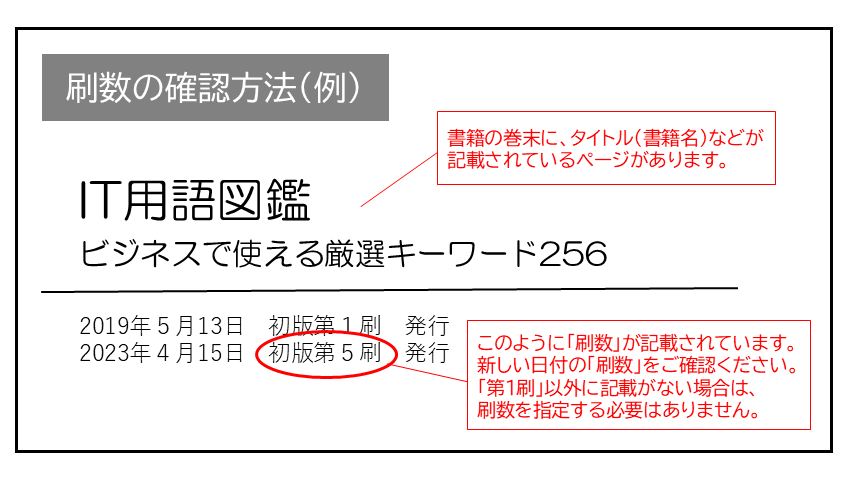

現在表示されている正誤表の対象書籍

書籍の種類:紙書籍

書籍の刷数:全刷

書籍によっては表記が異なる場合がございます

本書に誤りまたは不十分な記述がありました。下記のとおり訂正し、お詫び申し上げます。

対象の書籍は正誤表がありません。

| ページ数 | 内容 | 書籍修正刷 | 電子書籍訂正 | 発生刷 | 登録日 | ||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| 078 数式3.6.1の下の1-2行目の本文 |

|

未 | 未 | 1刷 | 2024.01.18 | ||||||

| 162 最初のInの1行目 |

|

2刷 | 済 | 1刷 | 2022.10.25 | ||||||

| 168 上から1行目 |

|

未 | 未 | 1刷 | 2025.01.20 | ||||||

| 245 全ページから続く「In」 |

|

3刷 | 済 | 1刷 | 2023.07.18 | ||||||

| 263 Out |

|

2刷 | 済 | 1刷 | 2022.10.25 | ||||||

| 268 上から1行目 |

|

未 | 未 | 1刷 | 2024.04.01 | ||||||

| 281 リストの上から13-19行目(スクレイピング先のページのHTML構造が変わったため) |

|

未 | 未 | 1刷 | 2024.04.22 |

.png)