深層学習教科書 ディープラーニング E資格(エンジニア)精選問題集

- 形式:

- 電子書籍

- 発売日:

- 2024年10月30日

- ISBN:

- 9784798180663

- 価格:

- 6,600円(本体6,000円+税10%)

- カテゴリ:

- ベンダー資格

- キーワード:

- #IT関連資格,#情報処理技術者試験,#開発環境,#システム運用

- レーベル:

- EXAMPRESS

- シリーズ:

- 深層学習教科書

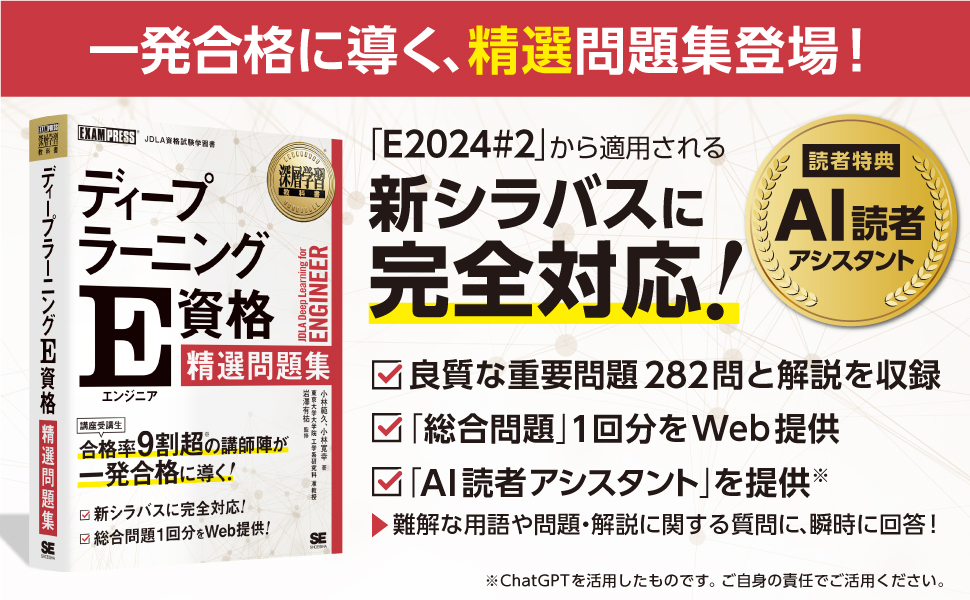

「E2024#2」試験から適用される新シラバスに完全対応!

〈本書の特長〉

●受講生の高い試験合格率を誇る講師陣の合格メソッドに基づいた、精選問題集。

●E2024#2以降の試験に対応した、唯一の問題集!

●良質な重要問題282問と解説を収録。

⇒出題範囲が広いE資格の中で優先して押さえるべき重要な論点をマスターできる。

●出題範囲を幅広くカバーした「総合問題」1回分をダウンロード提供。

⇒学習を終えた後に、復習や力だめしができる。

●読者特典として、本書の内容に完全対応した「AI読者アシスタント」付き!

⇒難解な用語や問題・解説に関する質問に、瞬時に回答してくれる!

〈監修〉

●岩澤有祐(いわさわ・ゆうすけ)

東京大学大学院工学系研究科准教授。2017年東京大学大学院工学系研究科技術経営戦略学専攻博士後期課程修了。博士(工学)、修士(情報理工学)。『深層学習』(KADOKAWA)共訳。

〈著者〉

●小林範久(こばやし・のりひさ)

株式会社Present Square 最高技術責任者(CTO)。

早稲田大学大学院修了。AI技術を活用したシステムサービスの開発やAI導入のコンサルティングに従事。東京大学松尾・岩澤研究室輪読会会員。

●小林寛幸(こばやし・ひろゆき)

株式会社Present Square 創業者/最高経営責任者(CEO)。

慶應義塾大学大学院修了。経営、事業企画及びAIを含む教育・コンサルティングに従事。社外取締役、非常勤講師等を歴任。東京大学AI経営寄付講座修了(2022)。

〈編者〉

●株式会社Present Square

日本ディープラーニング協会(JDLA)より認定を受けたエンジニア育成講座『DeepSquare』(認定No.00016)、AI動画像解析『Smart Counter-スマカチ-』等のサービスを提供。E資格、G検定、Generative AI Test等の専門資格を保有するコンサルタント及びエンジニアが、初学者から実務者向けの講義、PoC、サービス開発を支援。

<目次>

第1章:数学的基礎

第2章:機械学習

第3章:深層学習の基礎

第4章:深層学習の応用

第5章:開発・運用環境

Web提供:総合問題

※本電子書籍は同名出版物を底本として作成しました。記載内容は印刷出版当時のものです。

※印刷出版再現のため電子書籍としては不要な情報を含んでいる場合があります。

※印刷出版とは異なる表記・表現の場合があります。予めご了承ください。

※プレビューにてお手持ちの電子端末での表示状態をご確認の上、商品をお買い求めください。

(翔泳社)

お問い合わせ

内容についてのお問い合わせは、正誤表、追加情報をご確認後に、お送りいただくようお願いいたします。

正誤表、追加情報に掲載されていない書籍内容へのお問い合わせや

その他書籍に関するお問い合わせは、書籍のお問い合わせフォームからお送りください。

利用許諾に関するお問い合わせ

本書の書影(表紙画像)をご利用になりたい場合は書影許諾申請フォームから申請をお願いいたします。

書影(表紙画像)以外のご利用については、こちらからお問い合わせください。

-

よくある質問

①第3章大問2小問2の解答はDではなくBではないか?

ご指摘の通り、正しい解答は以下のとおり、Bとなります。

本書の誤りによりご迷惑をおかけし、誠に申し訳ございません。

-----------------------------------------

p.84:第3章大問2小問2正答

<誤>

正答:D. 多クラス分類は、訓練データのラベルをone-hotベクトルで表す。また、出力層にソフトマックス関数を用いて、クロスエントロピー誤差を最小化する。

<正>

正答:B. 多クラス分類は、訓練データのラベルを0または1の整数値で表す。また、出力層にシグモイド関数を用いて、バイナリクロスエントロピー誤差を最小化する。

p.86(上から3行目)

<誤>

よって、正解はD.となります。

<正>

よって、正解はB.となります。

-----------------------------------------

②第3章大問2小問2の解答が「B.」である理由について

小問2の問題は、「最も不適切な選択肢」を選ぶ設問です。Bは、ラベルの表現、出力層の活性化関数、誤差関数のすべてが不適切です。

A.出力層の活性化関数、誤差関数が一般的ではありません。技術的には可能です。

B.ラベルの表現、出力層の活性化関数、誤差関数のすべてが不適切です。技術的にも不適切です。

C.ラベルの表現が一般的ではありません。技術的には可能です。

D.ラベルの表現、出力層の活性化関数、誤差関数のすべてが適切です。

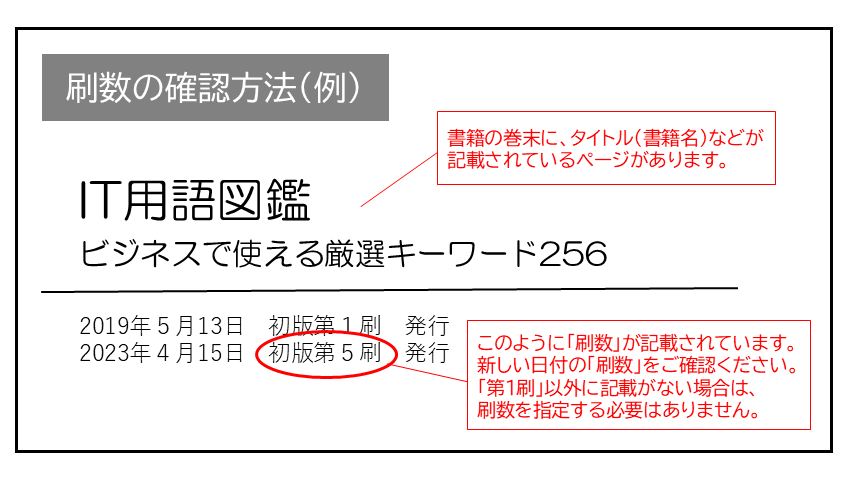

現在表示されている正誤表の対象書籍

書籍の種類:電子書籍

書籍の刷数:全刷

書籍によっては表記が異なる場合がございます

本書に誤りまたは不十分な記述がありました。下記のとおり訂正し、お詫び申し上げます。

対象の書籍は正誤表がありません。

| ページ数 | 内容 | 書籍修正刷 | 電子書籍訂正 | 発生刷 | 登録日 | ||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| 007 「●ベイズ則を用いた計算方法」上から4-5行目の数式 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 007 「●ベイズ則を用いた計算方法」上から9行目の数式 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 025 第2章大問1小問3の上から2-3行目 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 038 小問3「ここがポイント」2行目 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 038 「●コサイン距離」解説2行目 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 038 「●コサイン距離」解説3行目 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 038 「●マハラノビス距離」解説の上から3-6行目 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 038 小問3 A.~D.の解説(共通) |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 040 下から1-4行目 |

|

未 | 未 | 1刷 | 2025.02.20 | ||||||

| 043 大問3解説小問1の「A.」解説の上から2-4行目 |

|

未 | 未 | 1刷 | 2024.12.26 | ||||||

| 044 「●汎化誤差」数式1行目 |

|

2刷 | 済 | 1刷 | 2024.11.15 | ||||||

| 067 大問1小問1選択肢A.~D.の(い) |

|

2刷 | 済 | 1刷 | 2024.11.15 | ||||||

| 072 B.ReLUグラフの縦軸の数字 (C. Leaky ReLUグラフの縦軸の数字も同様) |

|

2刷 | 済 | 1刷 | 2024.11.15 | ||||||

| 074 上から4行目 |

|

未 | 未 | 1刷 | 2025.02.25 | ||||||

| 074 大問3小問5選択肢「D.」(上から2行目) |

|

未 | 未 | 1刷 | 2025.03.06 | ||||||

| 080 小問1正答B.の(い) |

|

2刷 | 済 | 1刷 | 2024.12.10 | ||||||

| 084 小問2正答(上から3行目) |

|

2刷 | 済 | 1刷 | 2024.11.01 | ||||||

| 085 大問②小問2「C.」の解説 |

|

未 | 未 | 1刷 | 2025.02.20 | ||||||

| 085 第3章大問2小問2解説「A.」の上から2行目 |

|

未 | 未 | 1刷 | 2025.01.08 | ||||||

| 086 上から3行目 |

|

2刷 | 済 | 1刷 | 2024.11.01 | ||||||

| 089 B.ReLUグラフの縦軸の数字 |

|

未 | 未 | 1刷 | 2025.02.19 | ||||||

| 094 上から3行目 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 096 大問3小問5正答「D.」および下から2行目 |

|

未 | 未 | 1刷 | 2025.03.06 | ||||||

| 117 下から7-8行目 |

|

未 | 未 | 1刷 | 2025.02.20 | ||||||

| 165 HINT 上から4-5行目 |

|

未 | 未 | 1刷 | 2025.02.18 | ||||||

| 166 「⚫️転置畳み込み」解説の上から3行目 |

|

未 | 未 | 1刷 | 2025.02.19 | ||||||

| 219 小問3の選択肢「D.」 |

|

未 | 未 | 1刷 | 2025.02.27 | ||||||

| 229 上から4-5行目 |

|

未 | 未 | 1刷 | 2025.03.14 | ||||||

| 231 上から5行目(選択肢「D.」の解説) |

|

未 | 未 | 1刷 | 2025.02.27 | ||||||

| 254 「コード3-大問37-3:Normalization(TensorFlow)」内の上から7行目および上から14行目 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 256 小問3の上から2行目 |

|

2刷 | 済 | 1刷 | 2024.12.03 | ||||||

| 267 「●GaussianFilter(ノイズ付与)」の見出し名および1行目 |

|

未 | 未 | 1刷 | 2025.02.20 | ||||||

| 302 下から4-5行目 |

|

未 | 未 | 1刷 | 2025.03.06 | ||||||

| 313 大問③・④小問2の正答 |

|

未 | 未 | 1刷 | 2025.02.20 | ||||||

| 314 小問2「C.」・「D.」の解説 |

|

未 | 未 | 1刷 | 2025.02.20 | ||||||

| 321 大問8小問3問題文の1行目 |

|

未 | 未 | 1刷 | 2025.02.27 | ||||||

| 321 大問8小問3選択肢A・Bの(あ)数式の右辺 |

|

未 | 未 | 1刷 | 2025.03.14 | ||||||

| 323 上から13行目(指示関数の数式) |

|

未 | 未 | 1刷 | 2025.02.21 | ||||||

| 323 下から1行目 |

|

未 | 未 | 1刷 | 2024.12.26 | ||||||

| 338 大問8小問3正答A(あ)数式の右辺と、下から2-3行目数式の右辺 |

|

未 | 未 | 1刷 | 2025.03.14 | ||||||

| 385 大問17小問3問題文の上から6行目 |

|

未 | 未 | 1刷 | 2025.03.14 | ||||||

| 402 「●VAEの目的関数と変分下限」上から3行目 |

|

未 | 未 | 1刷 | 2025.03.14 | ||||||

| 404 上から3行目 |

|

未 | 未 | 1刷 | 2025.03.14 | ||||||

| 408 下から3-4行目 |

|

未 | 未 | 1刷 | 2025.03.14 | ||||||

| 458 [TensorFlow]解説の上から9-10行目 |

|

未 | 未 | 1刷 | 2025.02.20 | ||||||

| DL-155 大問54・68小問1正答(総合問題第6章) |

|

未 | 未 | 1刷 | 2025.03.14 | ||||||

| DL-155 上から7-9行目 |

|

未 | 未 | 1刷 | 2025.03.14 |

.png)